Immagine tratta dal tour Power Up degli ACDC

Well, you ask me ’bout the clothes I wear

And you ask me why I grow my hair

And you ask me why I’m in a band

I dig doin’ one night stands

And you want to see me doin’ my thing

All you got to do is plug me in

High Voltage, AC/DC

T.N.T, 1975

Iniziamo l’anno esattamente da dove lo avevamo lasciato. Nell’ultima Side View del 2025, Bubble Shooter, avevamo discusso sull’intelligenza artificiale come possibile boom o possibile bolla, mettendo a confronto entusiasmo, valutazioni e fondamentali. Oggi ripartiamo dallo stesso tema, ma con una lente diversa. Non a caso, il titolo di questa Side View richiama il Power Up Tour degli AC/DC, che nel 2026 riporterà sul palco una delle band più elettriche della storia del rock, a oltre quarant’anni da Back in Black. Più di 200 milioni di album venduti, amplificatori che tornano a ruggire e un messaggio implicito: per continuare a suonare, serve potenza. Per molti anni anche l’intelligenza artificiale è stata raccontata come un fenomeno essenzialmente immateriale fatta di algoritmi, modelli, e codici, un progresso che sembrava muoversi in una dimensione quasi astratta, dove la velocità dell’innovazione dipendeva più dall’ingegno umano che dai vincoli fisici. Anche quando l’IA ha iniziato a permeare processi produttivi, servizi e mercati finanziari, la narrativa dominante è rimasta quella di una tecnologia “leggera”, scalabile e apparentemente indipendente dalle leggi dell’economia industriale tradizionale.

Negli ultimi due anni questa rappresentazione ha iniziato a incrinarsi. La diffusione dei modelli generativi, l’esplosione della domanda di calcolo e la corsa globale alla costruzione di infrastrutture dedicate hanno riportato l’IA su un terreno molto più concreto. Oggi l’intelligenza artificiale non è più soltanto una questione di software, ma un sistema industriale a tutti gli effetti: richiede capitali ingenti, catene di fornitura complesse, tempi di realizzazione lunghi e, soprattutto, grandi quantità di energia. È proprio in questo passaggio, dall’algoritmo alla rete elettrica, che si colloca il cuore del dibattito attuale. Da un lato, l’IA continua a promettere un salto strutturale di produttività, con applicazioni che spaziano dal cloud all’inferenza, dalla ricerca scientifica all’automazione dei processi. Dall’altro, il ritmo degli investimenti necessari per sostenere questa trasformazione sta crescendo a una velocità senza precedenti nella storia recente del settore tecnologico. Il ciclo di CAPEX degli hyperscaler ha assunto dimensioni tipiche dell’industria pesante, mentre il vincolo energetico, per anni considerato secondario, sta emergendo come uno dei principali colli di bottiglia del nuovo paradigma.

Questa tensione introduce una discontinuità rilevante rispetto ai cicli tecnologici del passato. L’IA richiede la costruzione ex novo di data center, reti di trasmissione, capacità di generazione e sistemi di raffreddamento. Tempi, costi e autorizzazioni non seguono la stessa logica esponenziale del software. Il rischio, sempre più evidente, è che l’ambizione tecnologica corra più veloce della capacità fisica di supportarla. In questo contesto, la competizione sull’intelligenza artificiale assume una dimensione che va oltre il mercato. La disponibilità di capitale resta abbondante, ma non è sufficiente. A fare la differenza saranno l’accesso all’energia, la resilienza delle supply chain e il ruolo dei governi, chiamati a trattare l’IA non più come un semplice settore economico, ma come un’infrastruttura critica per la crescita, la sicurezza e la leadership industriale.

Nella Side View di oggi proviamo quindi a spostare il focus proprio su questo punto: non se l’intelligenza artificiale rappresenti un boom o una bolla, ma quali siano i vincoli reali che ne determineranno traiettoria, tempi e distribuzione dei benefici. Perché, sempre più, il futuro dell’IA non dipenderà solo da chi sviluppa i modelli migliori, ma da chi saprà alimentare, finanziare e integrare nel mondo fisico la più grande infrastruttura tecnologica del nostro tempo.

Capacità vs consumo: una distinzione cruciale

Per inquadrare correttamente il tema energetico dell’intelligenza artificiale è utile partire da una distinzione spesso data per scontata, ma che in questo contesto diventa cruciale:quella tra capacità e consumo di energia. Le misure di capacità, espresse in MW o GW, indicano quanta potenza elettrica il sistema è in grado di fornire o assorbire in un dato istante, sotto i vincoli fisici della rete. Sono una misura istantanea, legata alla disponibilità continua di elettricità. Nel mondo dei data center e dell’IA, i carichi computazionali non sono intermittenti, ma richiedono potenza stabile, 24 ore su 24, 7 giorni su 7. Un singolo gigawatt di capacità equivale, in termini di fabbisogno istantaneo, a quello di una grande area urbana con circa 1,8 milioni di abitanti.

Le misure di consumo, espresse in TWh, indicano invece quanta energia viene effettivamente prodotta e consumata in un certo periodo di tempo. Sono utili per stimare l’impatto complessivo sulla domanda energetica, ma dicono poco sulla capacità del sistema di reggere picchi, carichi continui e rigidità operative. Un TWh può sembrare una quantità enorme di energia, ma distribuito nel tempo può risultare compatibile con sistemi che, dal punto di vista della capacità, sono già sotto stress.

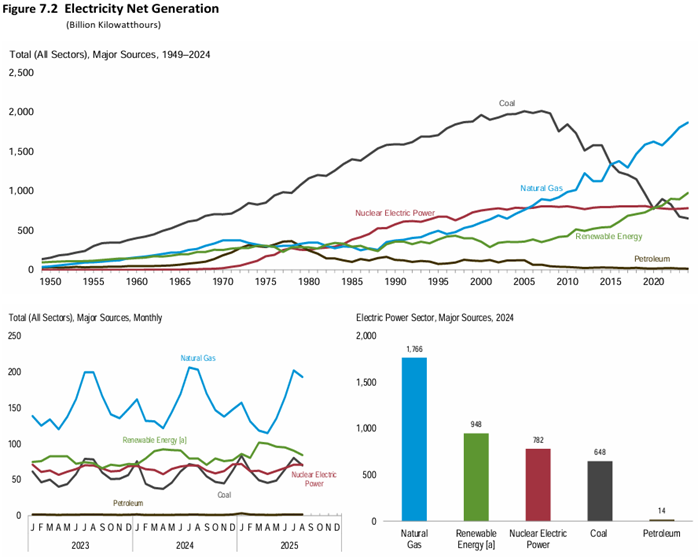

Il mix di generazione elettrica statunitense aiuta a inquadrare il contesto di partenza. Negli ultimi decenni il sistema si è progressivamente riallocato: il carbone è entrato in un declino strutturale, il petrolio è diventato marginale, il nucleare ha mantenuto un ruolo stabile come fonte di base, mentre gas naturale e rinnovabili sono diventati i principali driver della crescita della produzione elettrica. Le rinnovabili hanno introdotto una quota crescente di generazione intermittente, preziosa dal punto di vista ambientale ma complessa da gestire in un sistema che deve garantire continuità. Il gas naturale, al contrario, è diventato la vera spina dorsale della flessibilità: rapido da modulare, scalabile e relativamente economico. Il nucleare resta l’unica fonte non fossile in grado di fornire carico di base continuo, ma la sua capacità installata cresce lentamente, frenata da tempi autorizzativi, costi e vincoli politici. Nonostante questi limiti, alcuni hyperscaler stanno iniziando a considerarlo come una componente necessaria della strategia energetica di lungo periodo. Accordi come quello siglato da Meta con Oklo, che prevede prepagamenti per assicurarsi fino a 1,2 GW di capacità nucleare entro il 2030 attraverso piccoli reattori modulari, vanno letti non come una soluzione al vincolo energetico immediato, ma come un tentativo di assicurarsi oggi una fonte di potenza stabile e affidabile per il futuro.

Da questo punto in avanti, la questione energetica dell’IA smette di essere un tema astratto di transizione e diventa una questione molto concreta di fisica, capitale e tempi di realizzazione. Ed è su queste fondamenta che si gioca la sostenibilità del ciclo di investimento in corso.

Il vincolo energetico prende forma

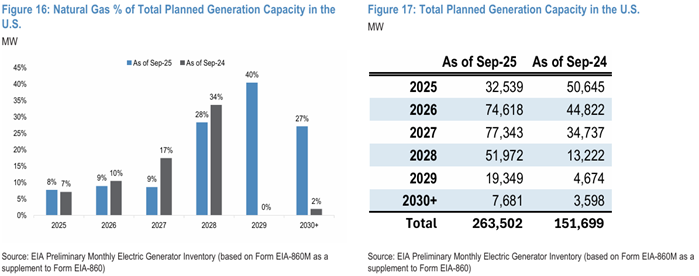

La distinzione tra capacità e consumo smette di essere teorica non appena si guarda ai numeri. I dati dell’EIA, rielaborati da JPMorgan, mostrano che la capacità di generazione elettrica pianificata negli Stati Uniti è aumentata in modo sostanziale nell’arco di appena dodici mesi. Le nuove stime parlano di oltre 260 GW di capacità complessiva pianificata, contro circa 150 GW nella rilevazione precedente. Un incremento di oltre 110 GW in un solo anno, che dà immediatamente la misura della pressione che si sta accumulando sul sistema elettrico.

Per rendere l’ordine di grandezza più intuitivo, 260 GW di capacità equivalgono, in termini di potenza istantanea, al fabbisogno di oltre 450 milioni di persone, 100 milioni in più dell’intera popolazione degli Stati Uniti. Non si tratta quindi di un aggiustamento marginale del sistema, ma di un’espansione che ha dimensioni paragonabili alla costruzione di decine di grandi aree urbane dal punto di vista energetico. È su questa scala che il ciclo dell’intelligenza artificiale sta iniziando a impattare il mondo fisico.

All’interno di questa espansione, il ruolo del gas naturale emerge con chiarezza. Il grafico di sinistra mostra come la quota di gas sulla capacità pianificata aumenti in modo significativo soprattutto nella finestra 2026–2029. Nonostante anni di narrativa focalizzata sulle rinnovabili, quando l’obiettivo è garantire potenza continua,il gas resta oggi la tecnologia di riferimento. Non perché sia la soluzione ideale in assoluto, ma perché è l’unica in grado di rispondere, nel breve e medio termine, ai requisiti operativi dei data center legati all’AI.

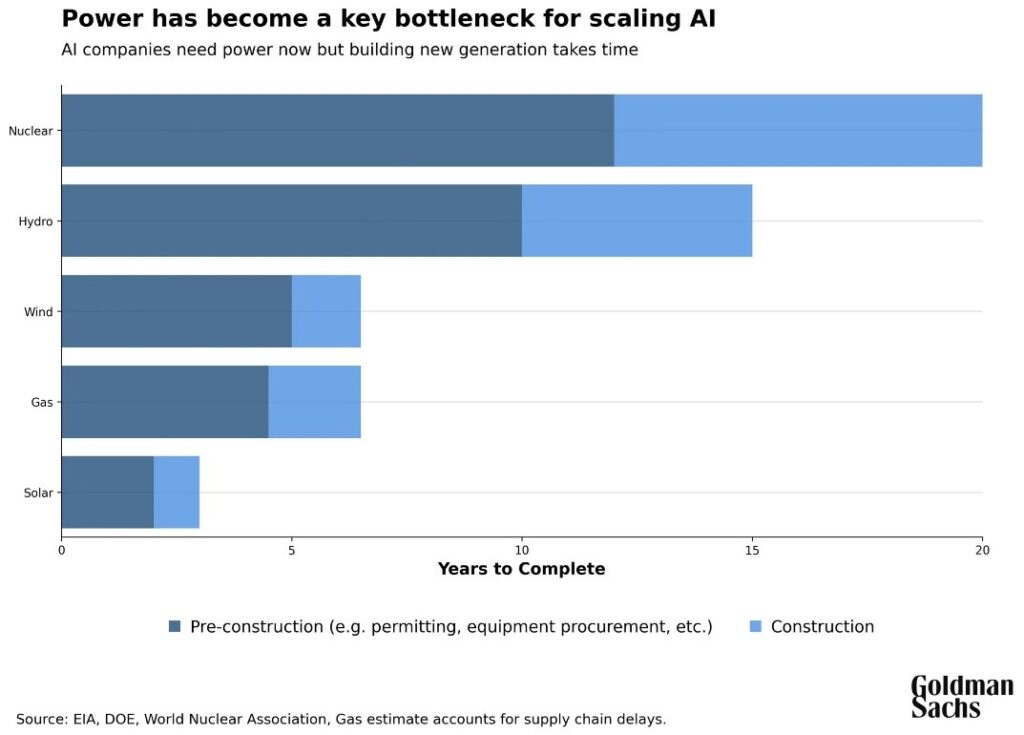

Il grafico di Goldman Sachs sposta l’attenzione su un elemento tanto banale quanto spesso ignorato: il tempo. Il vincolo, infatti, non è solo quanta capacità verrà costruita, ma quanto tempo serve per renderla effettivamente disponibile. Indipendentemente dalla tecnologia, la costruzione di nuova generazione elettrica richiede anni. Nel caso del gas naturale, che resta la soluzione più rapida e flessibile, tra iter autorizzativo, approvvigionamento e costruzione servono in media 5–7 anni. Per il nucleare l’orizzonte temporale si estende verso 15–20 anni, mentre anche per fonti apparentemente “veloci” come eolico e solare i tempi complessivi, una volta inclusi autorizzazioni, connessione alla rete e supply chain, superano spesso i 3–5 anni. L’intelligenza artificiale, al contrario, richiede potenza oggi. È in questo disallineamento temporale, strutturale e inevitabile, che si annida il vero collo di bottiglia del ciclo AI: la domanda di calcolo cresce a ritmi quasi immediati, mentre l’offerta di energia è vincolata a cicli di realizzazione che si misurano in anni, se non in decenni.

A complicare ulteriormente il quadro c’è un vincolo meno visibile, ma altrettanto stringente: la gestione del calore. La crescita dell’intelligenza artificiale non sta aumentando solo il consumo complessivo di energia, ma sta cambiando radicalmente la densità di potenza all’interno dei data center. Un rack tradizionale operava tipicamente tra i 10 e i 15 kW; i rack dedicati ai modelli AI di nuova generazione superano già i 100 kW e si muovono rapidamente verso livelli dell’ordine delle centinaia di kilowatt. A queste densità, il raffreddamento ad aria non è più sufficiente. Il passaggio al raffreddamento a liquido diventa quindi inevitabile. Questo, tuttavia, trasforma il data center da infrastruttura digitale a impianto industriale a tutti gli effetti. Cambiano i layout, aumentano i carichi strutturali, si introducono impianti idraulici dedicati e cresce la complessità ingegneristica complessiva. I tempi di progettazione e realizzazione si allungano, i costi aumentano e il legame con le risorse, i.e. energia e acqua diventa ancora più stringente. Anche da questo punto di vista, l’idea di un’AI facilmente scalabile entra definitivamente in crisi.

RACK

Un rack è la struttura fisica che ospita i server all’interno di un data center. È essenzialmente un armadio standardizzato in cui vengono installati computer, sistemi di rete e dispositivi di storage. Concentrando molte macchine in uno spazio ridotto, il rack consente di gestire in modo efficiente potenza elettrica, raffreddamento e cablaggi. Nel caso dell’AI, l’aumento della potenza dei server fa sì che ogni rack concentri oggi quantità di energia e calore senza precedenti.

Quando il costo dell’energia diventa un tema politico

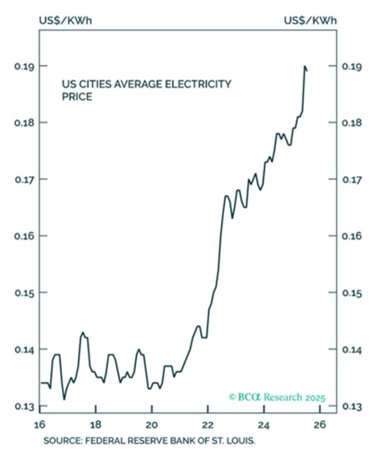

L’aumento dei prezzi dell’energia è il primo punto in cui il vincolo fisico si trasforma in un problema economico e, rapidamente, politico. Negli Stati Uniti, il prezzo medio dell’elettricità nelle aree urbane entra in una fase di rialzo strutturale a partire dal 2022, dopo anni di relativa stabilità.

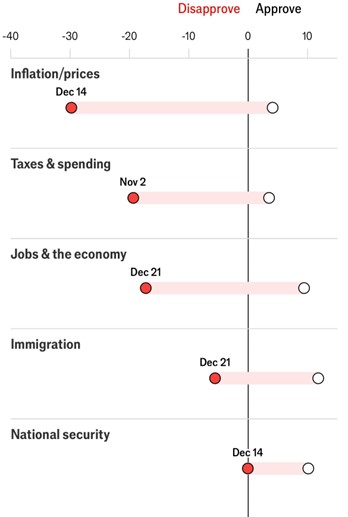

In un contesto in cui l’energia rappresenta una componente essenziale del costo della vita, anche incrementi apparentemente contenuti assumono rapidamente un peso macroeconomico e distributivo rilevante. Non sorprende quindi che il tema dell’inflazione, e in particolare dei prezzi dell’energia, resti uno dei punti di maggiore fragilità anche sul piano politico, come mostrano le difficoltà dell’amministrazione Trump nei sondaggi proprio sulle dinamiche dei prezzi e del costo della vita come mostra il grafico tratto dal The Economist qui sotto.

L’intervento dell’amministrazione federale sul mercato elettrico del PJM, il principale operatore della rete elettrica all’ingrosso negli Stati Uniti, segna un passaggio rilevante: quando l’aumento della domanda legata all’intelligenza artificiale inizia a riflettersi direttamente sui prezzi dell’elettricità, il tema diventa immediatamente politico. Il PJM, che serve oltre 65 milioni di persone in 13 stati federali, includendo la Virginia settentrionale, il più grande hub mondiale di data center, ha visto un’esplosione dei prezzi negli ultimi anni, attribuibile in parte significativa alla crescita dei carichi legati all’AI. Secondo Monitoring Analytics, la crescita dei data center ha contribuito a circa 23 miliardi di dollari di costi legati alla necessità di garantire nuova potenza elettrica disponibile quando serve, costi che vengono poi trasferiti dalle utility ai consumatori finali attraverso le bollette. È in questo contesto che l’amministrazione Trump e diversi governatori hanno chiesto a PJM di modificare il funzionamento del mercato, spingendo per un meccanismo che obblighi i grandi operatori tecnologici a finanziare direttamente la nuova capacità necessaria. Il piano prevede un’asta di capacità d’emergenza, attraverso la quale gli hyperscaler si impegnerebbero a sostenere fino a 15 miliardi di dollari di nuovi investimenti in generazione, e un’estensione dei limiti ai prezzi del mercato della capacità per proteggere i clienti residenziali. La pressione nasce anche da vincoli di affidabilità: nell’ultima asta, PJM ha rilevato che per il 2027 mancherebbero circa 6 gigawatt di potenza elettrica prontamente disponibile per garantire il funzionamento sicuro della rete nei momenti di massimo consumo. Si tratta di un deficit rilevante: 6 GW equivalgono, per ordine di grandezza, alla capacità di produzione di sei grandi centrali nucleari. In altre parole, se la domanda evolvesse come previsto e non entrasse nuova capacità, il sistema si troverebbe strutturalmente corto di potenza, con implicazioni dirette su affidabilità e prezzi dell’elettricità.

Il messaggio politico è esplicito: l’espansione dei data center non può tradursi automaticamente in bollette più alte per famiglie e imprese. Quando la crescita dell’AI inizia a incidere sui prezzi dell’energia e sulla stabilità della rete, il mercato viene affiancato e in parte forzato da interventi istituzionali volti a riallocare i costi verso i principali beneficiari della nuova domanda. Il caso PJM diventa così un esempio concreto di come l’energia stia rapidamente passando da input tecnico a nodo centrale di consenso, distribuzione dei costi e sostenibilità del ciclo dell’intelligenza artificiale.

USA vs Cina

Il vincolo energetico e infrastrutturale dell’intelligenza artificiale non viene affrontato in modo uniforme a livello globale. Al contrario, sta diventando uno dei principali punti di divergenza tra modelli di politica industriale. Il confronto più rilevante è quello tra Stati Uniti e Cina, che adottano approcci profondamente diversi nel modo in cui lo Stato interviene per sostenere tecnologie considerate strategiche, dall’AI all’energia necessaria per alimentarla.

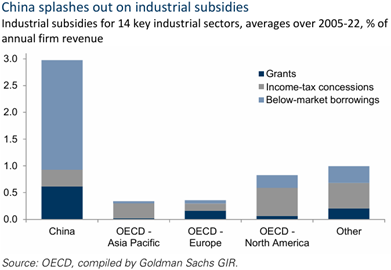

La Cina adotta un approccio diretto e olistico. I dati OCSE elaborati da Goldman Sachs mostrano come Pechino faccia ampio ricorso a sussidi industriali persistenti, combinando grant, agevolazioni fiscali e credito a condizioni inferiori a quelle di mercato. Il ruolo delle banche pubbliche e delle policy banks è centrale, così come il coordinamento lungo l’intera catena del valore. L’obiettivo è costruire capacità domestica su larga scala e ridurre la dipendenza dall’estero. Nel caso dell’intelligenza artificiale, questo modello si traduce in un intervento statale diretto nella creazione di scala industriale, con lo Stato che agisce come attore primario nella definizione di priorità, investimenti e tempi.

Gli Stati Uniti seguono invece un modello ibrido. Da un lato, utilizzano strumenti restrittivi per limitare l’integrazione tecnologica con la Cina come gli export controls, verifiche e vincoli sugli investimenti esteri e dall’altro stimolano selettivamente l’offerta domestica tramite incentivi fiscali e sussidi mirati. Iniziative come il CHIPS Act e l’Inflation Reduction Act riflettono questa impostazione: non una pianificazione industriale completa, ma un intervento focalizzato su nodi considerati critici, come semiconduttori, AI ed energia. Il finanziamento resta prevalentemente guidato dal mercato dei capitali, con lo Stato che assume il ruolo di abilitatore piuttosto che di finanziatore diretto.

Il confronto emerge anche osservando l’ampiezza e la natura del supporto pubblico. I fondi dedicati all’AI – dagli 8,2 miliardi di dollari del National AI Industry Investment Fund cinese, ai 20 miliardi di euro di seed funding europei, fino ai piani dell’Arabia Saudita che potrebbero arrivare a 100 miliardi di dollari – sono significativi in valore assoluto, ma restano marginali rispetto ai trilioni di dollari necessari per la realizzazione su scala globale di data center e reti energetiche. In entrambi i modelli, il ruolo dello Stato oggi è meno quello di sostituire il capitale privato e più quello di indirizzarlo, riducendo incertezze e colli di bottiglia. Negli Stati Uniti questo orientamento è diventato esplicito con la nuova amministrazione. L’approccio è chiaramente favorevole a una rapida espansione delle infrastrutture digitali: ordini esecutivi per accelerare lo sviluppo di AI e data center, semplificazione dei processi autorizzativi e forte sponsorship di iniziative come Project Stargate, che punta a mobilitare fino a 500 miliardi di dollari di investimenti infrastrutturali, con una prima tranche da 100 miliardi. Il supporto pubblico non assume la forma di un bailout, ma di un’abilitazione sistemica: accesso all’energia, rapidità di esecuzione e tempi compatibili con il ciclo dell’AI.

In sintesi, la Cina punta a costruire l’infrastruttura dell’AI attraverso un intervento statale diretto e coordinato, mentre gli Stati Uniti cercano di ottenere lo stesso risultato affidandosi al capitale privato, ma intervenendo in modo deciso sul contesto regolatorio e infrastrutturale. Due modelli diversi, con implicazioni profonde per la velocità di esecuzione, la distribuzione dei costi e il vantaggio competitivo nel ciclo globale dell’intelligenza artificiale.

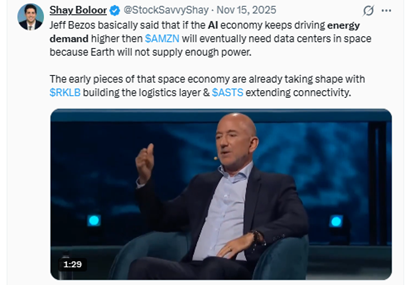

Power Up, davvero

A questo punto, la provocazione di Jeff Bezos smette di sembrare una battuta futuristica e diventa una metafora sorprendentemente efficace. Quando afferma che, se la domanda energetica dell’AI continuerà a crescere, un giorno potremmo aver bisogno di data center nello spazio perché la Terra non sarà in grado di fornire abbastanza energia, non sta suggerendo una roadmap industriale, ma evidenziando un punto chiave: il limite non è più il software, ma la potenza disponibile. Prima di guardare allo spazio, il sistema economico dovrà fare i conti con vincoli molto più terrestri: reti elettriche, capacità di generazione, autorizzazioni, consenso politico.

La vera linea di demarcazione del ciclo AI non passa quindi tra boom e bolla, ma tra chi riuscirà a trasformare l’innovazione tecnologica in infrastruttura funzionante e chi resterà bloccato nei colli di bottiglia fisici. Energia, tempi di realizzazione e coordinamento industriale sono diventati i fattori determinanti. È su questi elementi che si stanno già differenziando modelli economici, strategie aziendali e politiche pubbliche, come mostrano il caso PJM negli Stati Uniti o il confronto tra l’approccio americano e quello cinese.

In questo senso, l’intelligenza artificiale non è più una scommessa puramente digitale, ma un test di capacità esecutiva su scala industriale. I vincitori non saranno necessariamente quelli con i modelli migliori, ma quelli in grado di garantire potenza continua, infrastrutture affidabili e tempi compatibili con una domanda che cresce molto più velocemente dell’offerta. Come in ogni grande ciclo infrastrutturale, il capitale è necessario, ma non sufficiente.

Power Up diventa così una chiave di lettura del ciclo dell’intelligenza artificiale. Per continuare a crescere non bastano modelli più sofisticati o capitali abbondanti: servono infrastrutture ed energia. In un contesto in cui l’AI è ormai un fenomeno industriale, il vantaggio competitivo non sarà determinato da chi promette di più, ma da chi riuscirà a garantire potenza, affidabilità e tempi di esecuzione compatibili con una domanda in rapida espansione.

Approfondimento a cura di Nicola Lampis.

Lugano, 25 gennaio 2026